- Este fue el título de la ponencia impartida por Andrés A. García en ROBOTRADER 2022, en la que habló de la construcción de carteras cuantitativas dinámicas combinando series históricas de datos técnicos, empresariales, de consenso y de sentimiento. En las siguientes líneas se profundizará en este tema y veremos paso a paso la creación de una cartera de este tipo.

- Artículo publicado en Hispatrading 50.

Quienes nos hemos dedicado durante muchos años al trading algorítmico casi siempre hemos utilizado las series de precios en diferentes configuraciones y time frames como materia prima para el diseño y evaluación de todo tipo de estrategias. La idea subyacente a este planteamiento es la Hipótesis del Mercado Eficiente de Eugene Fama (1970) según la cual toda la información está contenida en los precios, por lo que otras fuentes de datos alternativas como los ratios financieros, las estimaciones de los analistas, los eventos corporativos o la actividad en las redes sociales se trasladan tan rápidamente a las cotizaciones que no es eficiente perder el tiempo con ellas. Dando por bueno este planteamiento, la mayoría de los desarrolladores y plataformas de creación de estrategias emplean un amplio arsenal de herramientas de análisis técnico para diseccionar las series de cotizaciones en busca de ineficiencias, patrones y movimientos cíclicos en los precios que permitan establecer las reglas de operativa.

Sin embargo, otro grupo de investigadores financieros pronto descubrieron algunas anomalías persistentes en el comportamiento de determinadas clases de activos que no se explican solo desde los precios y requieren la inclusión de múltiples fuentes de información o factores en los modelos explicativos de la dinámica de los mercados. De este modo nació un enfoque multifactorial mucho más rico y complejo que ha revolucionado en las últimas décadas la gestión profesional de carteras, dando lugar a una amplia gama de estilos de inversión y productos concretos basados en portfolios dinámicos.

La clave de este nuevo enfoque está en la identificación de factores susceptibles de generar alfa y su modelado a partir de series de datos basadas en ratios fundamentales, estimaciones de los analistas y social media que nos permitan verificar nuestras hipótesis de trabajo y evaluar las estrategias desarrolladas.

Así que nuestro punto de partida será explicar ¿qué es un factor? Para ello proponemos cinco definiciones desde los distintos ámbitos de la actividad inversora:

- Académica: Para los investigadores son el origen de cualquier sesgo o ineficiencia en las formaciones de precios. De este modo “momento”, “crecimiento”, “tamaño”, “valor”, “volatilidad” o “estacionalidad”, una vez formulados en términos cuantitativos, se convierten en causa explicativa del exceso de retorno en determinados valores y clases de activos.

- Estadística: Los factores son parámetros adicionales introducidos en un modelo de regresión con el que tratamos de capturar la dinámica de los mercados. Cuando un modelo aplicado a diferentes series temporales pierde valor explicativo o genera mucho ruido se van añadiendo más factores. De ahí que el CAPM (Capital Asset Pricing Model) que en su versión original solo contaba con el factor mercado, fuese complementado poco después con los modelos de Fama y French de 3, 4 y 5 factores o con los más recientes modelos BSV y AQR de 4 factores.

- Inversora: Desde un punto de vista inversor y meramente pragmático los factores son motivos para mantener en cartera determinados activos de los que se espera un rendimiento superior al mercado en un horizonte temporal dado.

- Gestora: Para el gestor de carteras los factores son criterios de selección de activos que dan lugar a una amplia gama de estilos de inversión.

- Algorítmica: Desde el diseño de estrategias los factores son reglas de operativa en un modelo cuantitativo de cartera. Estas reglas se implementan bien como criterios de selección de activos bien como subsistemas de entrada, salida y gestión del tamaño de la posición en los portfolios dinámicos.

En la Tabla 1 mostramos los factores más estudiados por el mundo académico y las series de datos empleadas en el modelado de cada uno de ellos:

| FACTORES | SERIES | |

| VALOR | Valor en libros / Precio

Cash Flow / Precio |

Ventas /Precio

PER |

| TAMAÑO | Capitalización de mercado

Número de empleados |

Volumen diario en dólares |

| CRECIMIENTO | Valor actual – valor anterior

Incremento de las ventas Variación EPS |

Variación EBITDA

Volumen de negocio |

| SENTIMIENTO | Cambios en las recomendaciones

Precio de consenso |

Previsiones de EPS, E/P y dividendo |

| CALIDAD | Rentabilidad sobre fondos propios

P/AFFO ratio |

Rentabilidad sobre los activos

Margen de beneficio |

| RIESGO OPERATIVO | Z-Score de Altman

Piotroski F-score |

Beneish M-Score

Sloan Ratio |

| TÉCNICOS | Tendencia

Reversión Volumen |

Momento

Lateralidad Soporte-Resistencia |

| VOLATILIDAD | Beta histórica,

Ratio Put/Call |

Volatilidad implícita

Std. Dev. diaria |

| ESTACIONALIDAD | Mes del año

Efecto TOM |

Día de la semana

Principio-fin de año. |

Tabla 1.

Por ejemplo, para construir un ranking o sistema de clasificación basado en empresas de “crecimiento” se emplean series como el volumen de negocio, incremento de las ventas o variación del EBITDA, y se asigna una ponderación a cada una de ellas. Otros factores, como el riesgo operativo, son más complejos y se basan en ratios que integran varias series. En esta categoría tenemos el Z-Score de Altman, que mide el riesgo de quiebra de una empresa o el F-Score de Piotroski empleado como estimador de su fortaleza financiera.

La periodicidad de estas series es muy variable; las que toman como base la publicación de resultados empresariales son de tipo trimestral, otras pueden ser de tipo mensual, semanal o diario. También hay que diferenciar si se basan en estimaciones o en datos publicados. Las estimaciones tienen frecuencia más alta, mayor volatilidad y más potencial predictivo, mientras que los datos publicados son más estáticos y se trasladan inmediatamente a los precios, por lo que su valor predictivo es nulo. Sin embargo, son útiles para hacer análisis retrospectivos.

Desde nuestro punto de vista cuantitativo, lo relevante es que, una vez que se dispone de todos estos datos históricos convenientemente filtrados y serializados, se pueden construir modelos dinámicos de cartera y analizar su evolución en el tiempo. En la imagen inferior mostramos algunas de estas series fundamentales:

El proceso de construcción de carteras dinámicas basadas en este tipo de ratios no difiere del de creación de estrategias con series temporales, salvo por los dos siguientes matices:

- El desarrollador debe tener conocimientos de análisis fundamental para hacer un uso adecuado de los diferentes ratios financieros que afectan a la evolución de las empresas y construir reglas coherentes con el conjunto de factores que se quieren potenciar.

- Debemos huir de la multicolinealidad o excesiva correlación entre las distintas variables explicativas del modelo. Cuando se dispone de decenas de magnitudes financieras hay que tener en cuenta que muchas de ellas están estrechamente relacionadas y apuntan en la misma dirección. Por lo que al incorporarlas en las reglas de la estrategia no estamos mejorando calidad del modelo sino aumentando innecesariamente su complejidad.

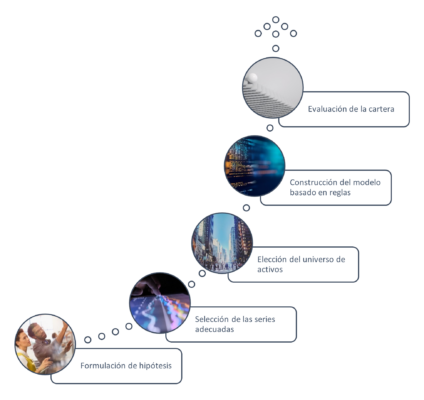

En la Figura 2 se muestra el esquema general que debe seguir la creación de este tipo de estrategias:

El primer paso – y a veces el más delicado – es la formulación de una hipótesis de trabajo que explique alguna anomalía o ineficiencia en el retorno de los activos y que, una vez formalizada, pueda suponer alguna ventaja a explorar. En general me gustan las hipótesis de amplio espectro, que afectan a un grupo de activos o sector de la economía y suelo huir de aquellas que solo son aplicables a un reducido número de valores. La clave de una buena hipótesis es que pueda ser modelada de forma precisa y evaluada en algún universo de activos.

Algunas hipótesis sencillas pueden formularse como un mero interrogante. Por ejemplo:

- ¿Las empresas con menor porcentaje de posiciones cortas tienen mejor rendimiento a largo plazo?

- ¿Qué genera más rentabilidad a largo plazo, la inversión en valor o en crecimiento?

- ¿Las empresas con un alto y sostenido incremento de las ventas tienen mayor rentabilidad?

- ¿Los valores con mayor volatilidad histórica tienen mejores expectativas de beneficio?

- ¿Qué es más eficiente? ¿la diversificación por sectores o por estilos de inversión?

Todas ellas son claramente modelables mediante reglas discretas basadas en series de datos de los tipos que hemos mencionado. Para evaluarlas tenemos dos opciones; bien elaborando un ranking o sistema de clasificación que se actualizaría dinámicamente en cada rebalanceo bien construyendo un sistema de filtros sucesivos que nos permitan ir reduciendo el universo de activos hasta quedarnos con el grupo que satisface la hipótesis. La diferencia entre ambos métodos es que en el primer caso tenemos una lista de empresas puntuadas según el grado de cumplimiento de las reglas, mientras que en el segundo tenemos el conjunto en bloque de las que satisfacen los criterios. En muchos modelos de cartera se pueden combinar ambos métodos.

El segundo paso es seleccionar las series de datos necesarias para construir el modelo y validar la hipótesis. Se pueden combinar en el mismo constructo series de tipo técnico, fundamental y de sentimiento. Lo importante es disponer de datos de calidad y contar con un histórico suficientemente grande (10-20 años) que contenga los diferentes regímenes de los mercados. El time frame afecta al modo en que se evalúan las reglas del portfolio. Si únicamente empleamos series mensuales es absurdo rebalancear la estrategia en intervalos semanales o diarios.

Los universos son los grupos de empresas cotizadas en los que se va a evaluar la estrategia. Un universo puede corresponderse con un índice general, un área geográfica, un sector de la economía o un conjunto de empresas según su capitalización. En muchos casos el tipo de universo condiciona la lógica global del portfolio y las reglas a implementar. Por ejemplo, si elegimos el universo de las nano-caps debemos renunciar a series basadas en estimaciones de consenso ya que las empresas de tan baja capitalización no suelen ser objeto de estudio por parte de los analistas.

El siguiente paso es el diseño de la lógica. Cuando se trata de portfolios dinámicos debemos meter en esta categoría los siguientes componentes:

- Sistema de ranking o criterios de clasificación.

- Reglas de selección de activos (incluyendo subsistemas de entrada, salida y cobertura).

- Política de rebalanceos.

- Tamaño de la posición o fórmulas de asignación de capital.

Por último, la evaluación, constituye la prueba de fuego tanto si se trata de corroborar una hipótesis de trabajo como de validar en profundidad una estrategia plenamente funcional. Un elemento fundamental en toda evaluación es el motor de backtesting. Éste debe ser realista, preciso y simular todas las configuraciones posibles de los mercados. Así mismo, debe contar con mecanismos que minimicen el impacto de determinados sesgos como los de supervivencia, anticipación o selección.

Sobre las distintas formas de realizar un backstest ya hemos hablado abundantemente en otros artículos y aquí no podemos detenernos. Bástenos recordar que existen dos aproximaciones generales; período único y periodos múltiples. En el primer caso todos las estadísticas y gráficos hacen referencia al mismo período, independientemente de que se trate de la región in-sample u out-sample. En el segundo caso se realiza la evaluación en muchos cortes temporales, siguiendo metodologías como el rolling backtest o la validación cruzada K-fold, y se extraen las estadísticas de cada periodo y los datos promedio. De este modo se obtienen resultados más realistas.

Seguidamente iremos creando paso a paso una cartera de este tipo:

PASO 1.- Hipótesis de trabajo

Formulación de la hipótesis:

“Las empresas con sentimiento positivo y elevado margen de negocio tienen en el medio y largo plazo un rendimiento superior a su mercado de referencia”.

Esto implica que buscamos empresas con las siguientes características:

- Sentimiento positivo, estimado indirectamente por las valoraciones de los analistas o directamente por la actividad del mercado, analizando, por ejemplo, el porcentaje de posiciones cortas sobre el total de acciones en circulación.

- Elevado margen de negocio, estimado de forma estática (TTM trimestral, anual) o dinámica (rolling TTM).

- Amplio espectro de empresas de todos los sectores de la economía excepto las de muy poca liquidez.

PASO 2.- Selección de las series

Para la realización de esta cartera combinaremos tres tipos de series:

- Margen de negocio (GMgn%). Entendido como el porcentaje de ingresos una vez descontados los gastos directos de producción. En la plataforma Portfolio 123 que hemos utilizado para este estudio, disponemos de varias series sobre este ratio. Hemos probado las trimestrales, anuales y ventana deslizante de 12 meses. Nos quedamos con esta última. También nos interesa comparar el margen de negocio relativo al sector al que pertenece cada empresa.

- Short Interest (SI#FF). También emplearemos la serie del porcentaje de posiciones cortas sobre el total de acciones en circulación, cuyos datos son de tipo quincenal.

- Precios y volúmenes; Buscaremos que los activos tengan un volumen medio suficiente para evitar los valores ilíquidos y emplearemos una media móvil de los cierres diarios del benckmark de referencia como filtro de entrada.

PASO 3.- Universo de activos

Dado que queremos validar nuestra estrategia en un amplísimo grupo de activos pertenecientes a todos los sectores de la economía, elegimos como benckmark al Russell 3000 y, como universo, a todos los activos de este índice estadounidense.

PASO 4.- Construcción del modelo

Para verificar nuestra hipótesis podemos elaborar un ranking específico, un conjunto de reglas discretas que actúen como filtros de selección de activos o una combinación de ambos. Optamos por esto último, dado que la aplicación ya incorpora un ranking de sentimiento preconstruido.

- Ranking de sentimiento. El sistema de clasificación, mostrado en la Figura 3, es una suma ponderada de los siguientes ratios:

Como vemos, tienen mayor peso (45%) la revisión al alza de las estimaciones de beneficio por acción (EPS), seguidas de el factor sorpresa (25%), que se calcula como la diferencia entre el beneficio estimado y el actual, las recomendaciones de los analistas (15%), de las que interesa la variación y el promedio, y por último el interés en corto (15%).

Aplicando este sistema de clasificación al Russell 3000 en una ventana de 20 años obtenemos las siguiente distribución del retorno anualizado al agrupar las empresas del índice en 20 percentiles. La barra roja de la izquierda es el retorno del índice. Como podemos ver, en la Figura 4, las empresas situadas dentro de los dos últimos percentiles (90-95 y 95-100) son las que obtienen los mayores retornos.

Por tanto, nuestra estrategia de selección consistirá en elegir en cada rebalanceo las empresas situadas en los percentiles más altos y mantenerlas en cartera durante el período siguiente.

- Reglas de entrada y salida. Además del ranking, incorporamos varias reglas discretas que serán evaluadas en cada rebalanceo:

Entramos largos si se verifican las siguientes condiciones:

- Volumen medio de las 10 últimas sesiones > 50.000 títulos.

- Margen bruto en una ventana de 12 meses > 70%

- Margen bruto del activo 5% superior al de su grupo industrial.

- Porcentaje de cortos sobre el total de acciones en circulación < 2%

- Precio del índice ($RUA) por encima de su media simple de 20 sesiones.

Así quedarían las reglas en el editor de la plataforma Portfolio 123, tal y como se muestra en la Figura 5:

Para las salidas establecemos las siguientes reglas:

- Cuando un valor cae por debajo del valor 60 dentro del ranking. Considerando que el número máximo de activos en cartera es de 30, estamos permitiendo una caída del doble antes de sacarlo del portfolio.

- Porcentaje de beneficio en un periodo dado es superior al 60%. Lo que equivale a establecer un profit target que preserva el exceso de retorno en situaciones extremas y muy infrecuentes.

Estas son las reglas en la plataforma:

- Política de rebalanceos. Tras probar diferentes configuraciones, optamos por una frecuencia mensual. Frecuencias superiores (semanales, diarias) generan mayor gasto en comisiones y una merma del retorno y, frecuencias inferiores, conducen a una cartera más estática y con menor poder adaptativo.

- Otros parámetros de la simulación:

- Capital inicial: $100.000

- Número máximo de activos en cartera: 30

- Tipo de asignación: Equiponderada.

- Comisiones: 0,005 cts. por acción.

- Período: 2001-2022.

PASO 5.- Evaluación del modelo

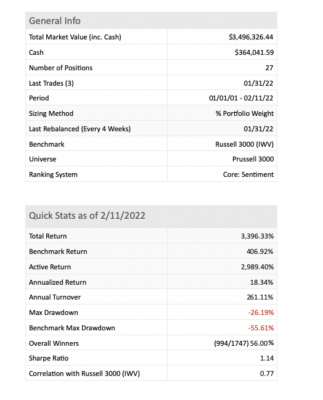

Empleando la herramienta de Backtesting de Portfolio 123 procedemos a una evaluación preliminar del portfolio con los parámetros de la simulación anteriormente señalados. Los resultados que obtenemos son los que se ven en la Tabla 2:

Como podemos apreciar los resultados del modelo son muy superiores a los del índice de referencia, tanto en retorno anualizado como en DD, el cual se reduce prácticamente a la mitad. Como consecuencia de ello el ratio de Sharpe se sitúa en 1,14 poniendo de manifiesto que el retorno ajustado por riesgo es muy favorable en esta cartera dinámica.

En la Figura 7 tenemos el gráfico del equity curve. Podemos ver cómo la clara ventaja del retorno acumulado obtenido por la cartera se mantiene por encima del benchmark prácticamente durante todo el histórico, tal y como se muestra en la Figura 7:

También observamos que el DD del portfolio se mantiene siempre por debajo del Russell 3000. Esto se debe fundamentalmente al filtro de la media móvil que, en la práctica, actúa como un mecanismo de cobertura, impidiendo el posicionamiento en nuevos activos cuando el contexto es bajista. Esto deja su huella en los profundos dientes de sierra que vemos en los gráficos del capital invertido y número de posiciones.

En cuanto al tipo de empresas en los que invierte la cartera, analizando los porcentajes globales de asignación en todo el histórico vemos claramente un sesgo hacia las empresas del sector financiero (45,01%), tecnológico (32,74%) y sanitario (15,28%) y, en menor medida, las de tipo cíclico (3,78%) y las utilidades (3,19%).

CONCLUSIONES

Hasta aquí hemos mostrado un ejemplo de cómo se pueden validar hipótesis de trabajo y construir carteras dinámicas cuando disponemos de series históricas de calidad basadas en ratios fundamentales y de sentimiento. No nos gusta el data-mining y preferimos partir siempre de hipótesis sencillas que expliquen alguna anomalía e ineficiencia en el retorno de los activos susceptible de generar alfa. Esta es, a mi juicio, la parte del desarrollo de modelos cuantitativos y a la que más tiempo debemos dedicar. El resto no es más que elegir las reglas apropiadas para formalizar dicha hipótesis y validarla mediante un motor de backtest en un histórico suficientemente largo. Aplicaciones como Portfolio 123 permiten realizar estas tareas en un entorno intuitivo y fácil de usar.

Este es el primer paso, después hay que construir un portfolio plenamente funcional y adaptado a nuestras necesidades, considerando un conjunto de restricciones, un estilo inversor y un nivel de aversión al riesgo. Ello implica la incorporación más reglas, como fórmulas para gestionar dinámicamente el tamaño de la posición o algún mecanismo más eficiente de cobertura.

Ni que decir tiene que también sería necesario un proceso de evaluación más completo, incluyendo análisis in-sample / out-sample, rolling backtests y simulaciones de Montecarlo. Pero esto ya sería materia para otro artículo.